当海量数据随着新科技的出现而大量涌入人们的生活,数据中心也需要更迅速的发展,以应对存储、移动和分析数据时所面临的内存挑战。

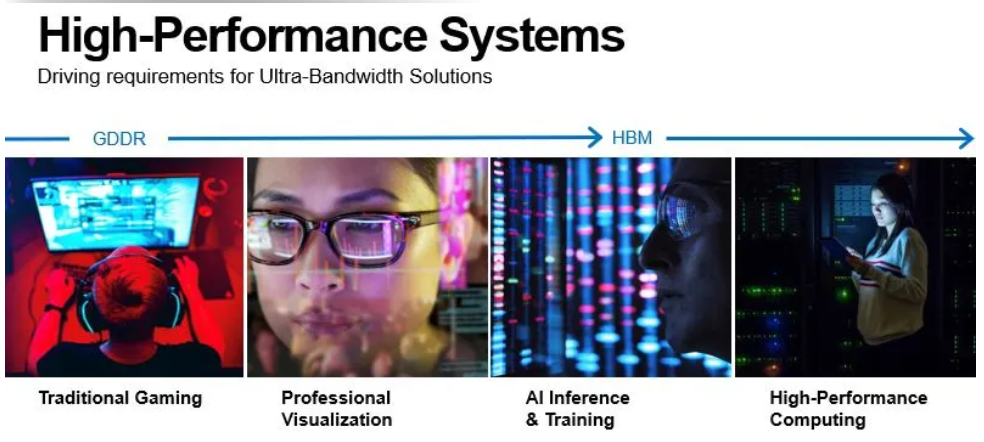

数据中心的发展主要由四种高性能应用趋势所推动,主要集中在个人电脑领域的传统游戏与专业视觉应用多采用快速 GDDR 内存。随着人工智能(AI)训练和推理以及高性能计算的出现,数据中心需要更多使用极速内存,即高带宽内存(HBM)。在这些领域工作的应用架构师需要找到更高的带宽以应对新局面。

伴随技术发展,数据呈现倍速增长趋势。据IDC《2021年全球数据圈(Global Datasphere 2021)》报告,2018年全球数据总量为 36 泽字节,2020 年翻倍为64 泽字节,2024 年将再次翻倍,达到 146 泽字节。

AI、深度学习、机器学习都需要海量数据为基础。在智能运算方面,AI将带来超越人类主导发现的新洞察。过去,我们为基础设施编写计算程序,如今我们利用海量数据来训练AI,从而使其服务于智能农业、个性化教育和精准医疗等广泛领域。

美光通过提供 GDDR 和 HBM 等超带宽解决方案,赋能分析引擎,帮助 AI 训练算法。例如,一个拥有超过 13 亿参数的 AI 模型无法放入单个 GPU(即使是拥有 32GB 内存)中,但扩展内存容量可以让更大的模型/更多的参数留在离核心计算更近的地方。

通过增加带宽和容量以减少内存和存储解决方案带来的延迟,美光正通过加速实现洞察,帮助客户获得更大的竞争优势。

基于加速器的多组件异构方法

数据中心的基础设施被重新定义,以应对数据密集型工作负载、应用程序的增长以及不断演变的应用场景和新业务机会。数据中心在传统定义中以 CPU 为中心,通过使用内存(如 DDR4)和存储(如 SSD)处理数据。

随着 AI 等现代应用场景带来的更多工作负载,传统架构发展已达瓶颈,无法让 CPU 以所需的高性能速度运行。

为缩小性能差距,当下的解决手段是采用专门硬件以解放 CPU 的某些功能。这种基于加速器的新计算模式正逐渐成为异构数据中心发展的关键。现代数据中心的新架构部署了各种组件,分别侧重于提供特定功能或者处理不同类型和格式的数据,从而显著提高整个系统的性能与运算速度。

对于使用 DDR4(很快将是 DDR5)计算内存的传统 CPU,美光添加了用于加速的GPU以及用于其他功能的 FPGA 和 ASIC。现代数据中心可以随意搭配不同的计算功能,同时,使用不同类型的内存搭配运算来满足处理各种工作负载能是极富性价比的选择。

这正是 HBM 出现的原因——它可以让性能更上一层楼。Micron HBM2E 作为最新一代的HBM,也是美光最快的 DRAM,可以更好的赋能客户。

HBM2E:超带宽解决方案中的明星

美光通过不断改善内存解决方案而引领市场发展,并凭借满足新兴市场应用不断变化的需求,从而改变世界。

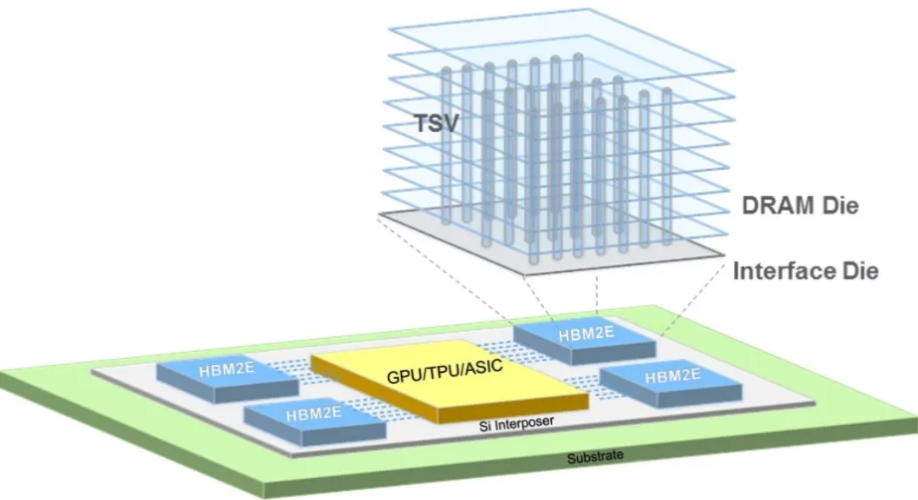

HBM2E 使用硅通孔(TSV)通道来构建垂直堆叠的 DRAM。(详细信息请参阅美光技术简报“集成并使用HBM2E内存”。)美光研发堆叠 DRAM 已有 20 年的历史,并获得数千项专利。(美光研发主管 Akshay Singh 的文章“堆叠硅奇迹”中有更详细的阐述。)在未来的堆叠式 DRAM 创新研究中,美光计划通过开发新产品以满足更多数据密集型工作负载的高性能和低功耗需求。

美光用于 HBM2E 的垂直堆叠 DRAM,并通过硅通孔(TSV)通道连接各层

高带宽内存的架构在业界对于带宽、功耗和外形尺寸方面的需求方面被寄予厚望。这一架构现在是 AI 行业标准内存解决方案,并广泛应用于数据中心。HBM2E 是 HBM 系列产品的第三项标准,它提供了非常宽的多通道 I/O——即 1,024 位宽,拥有非常短的物理通道并且能在极小的尺寸上实现极高的内存密度。

HBM2E位于靠近 GPU 或 CPU 的中介层,通常被放置在同一个封装或者散热机箱中。HBM2E 具有极宽的 I/O 总线和更高的密度,为现代数据中心基于加速器的计算模式提供了所需的高性能和高能效。

HBM2E展现的更强的 I/O 性能、带宽和能效使其成为美光超带宽解决方案产品线的基石。关于数据中心加速器内存产品线和美光高性能内存的逐项比较,请参阅白皮书“超带宽解决方案的需求”中的表 1。

结语

随着高性能应用需求推动着下一代系统架构和异构数据中心的发展,美光 HBM2E 内存和超带宽解决方案提供了关键的内存和先进的系统性能,从而帮助将数据转化为洞察。

我要赚赏金

我要赚赏金