简介

最近DeepSeek超级火,各个媒体、公众号、各大博主都在分享使用DeepSeek. 非常感谢deepseek的开源也可以让我们都使用上本地部署的DeepSeek而免去token的限制。那么本篇教程将和大家分享如何本地部署DeepSeek R1的蒸馏版模型到本地环境。

Ollama简介

Ollama 是一个开源项目,专注于在本地运行、创建和分享大型语言模型(LLMs)。它支持多种模型,包括 Llama 2、Code Llama 等,适用于文本生成、代码编写等任务。Ollama 提供命令行工具,便于用户与模型交互,并支持模型的自定义和共享。其优势在于本地运行,确保数据隐私,同时具备灵活性和可扩展性。

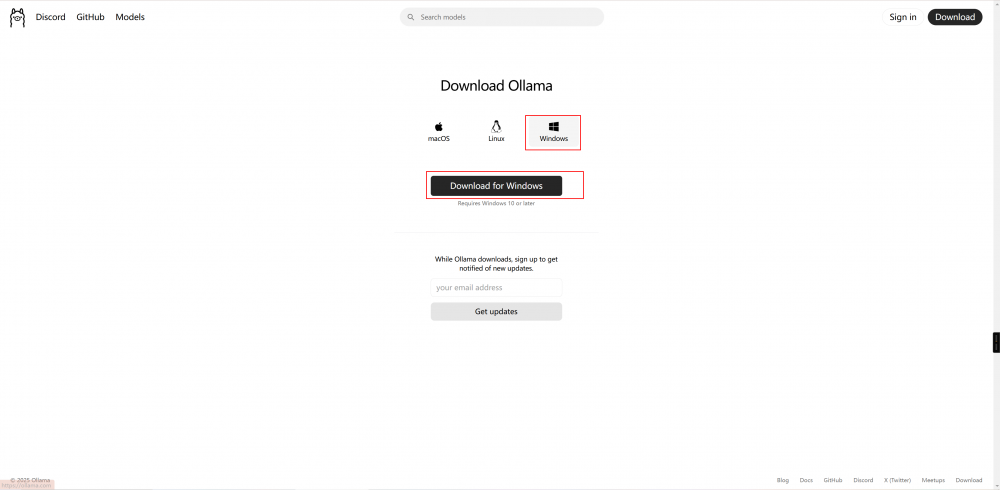

1- 下载Ollama并且安装https://ollama.com/download

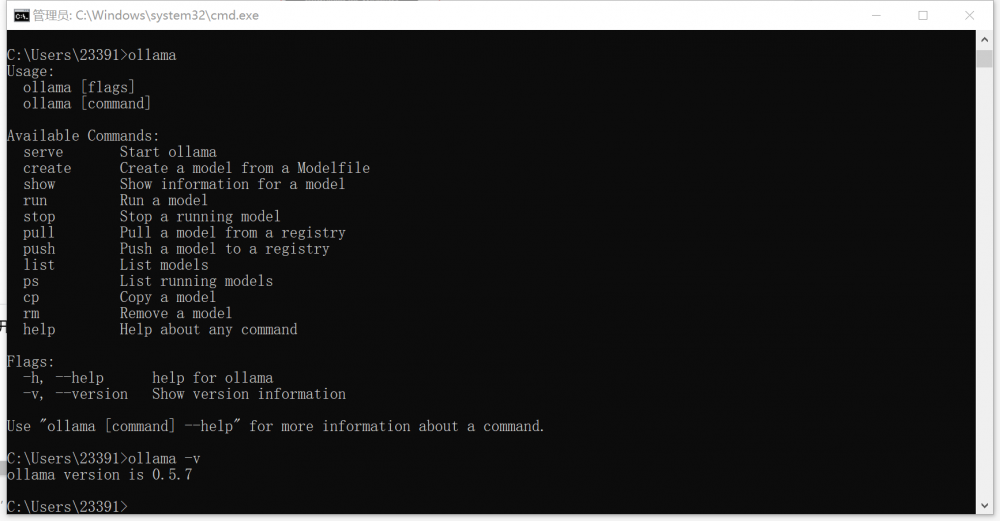

2- 安装到本地后可以打开CMD使用控制台测试是否安装成功

2- 安装到本地后可以打开CMD使用控制台测试是否安装成功

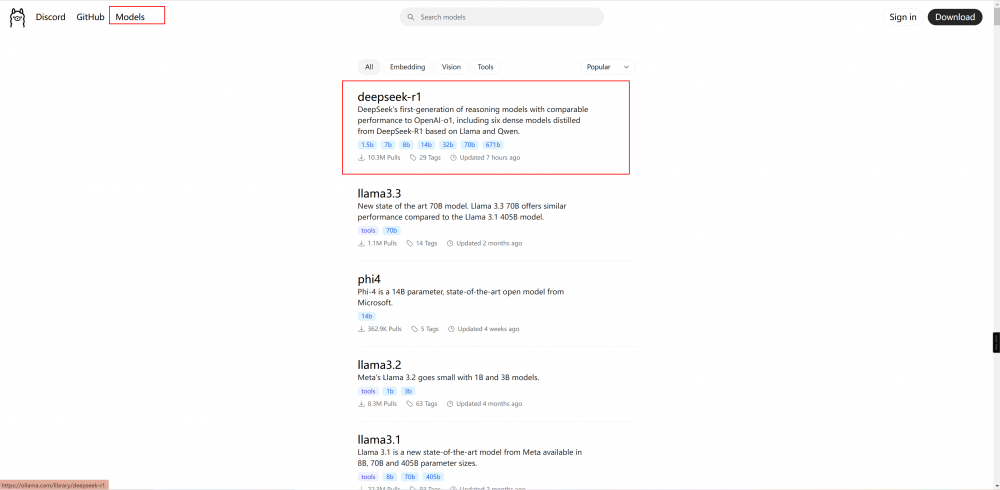

3- 下载Deepseek 蒸馏版本的模型。

点击进去, 根据自己电脑的GPU配置选择不同的版本

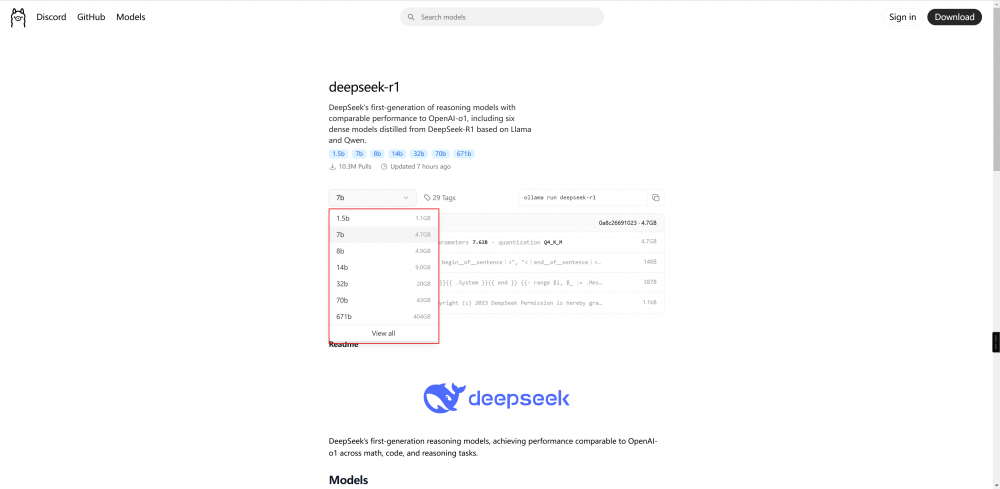

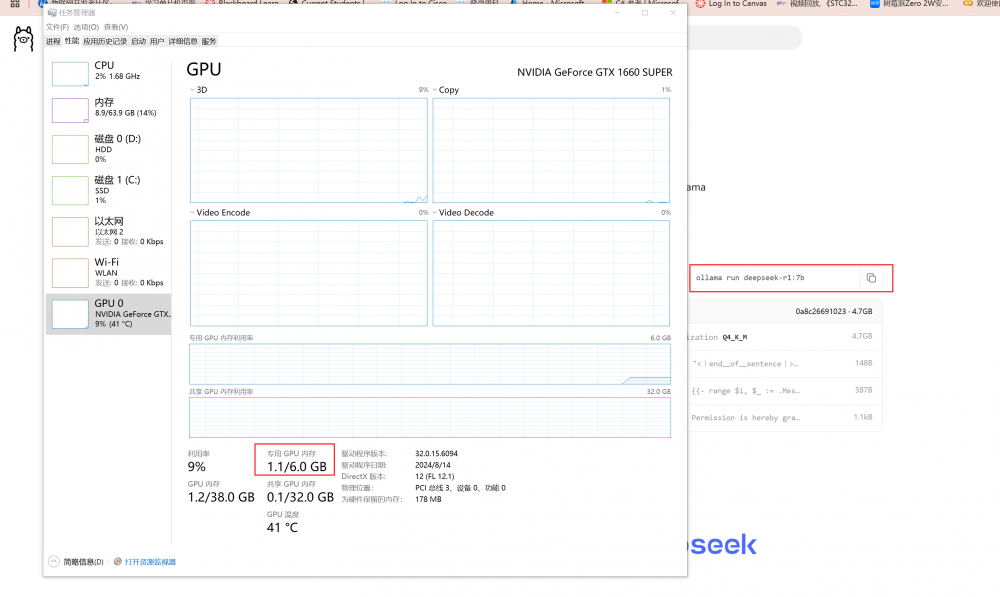

我这个电脑显卡的显存是6GB因此我选择了7B的版本。 拷贝Ollama命令,并且在控制台运行

我这个电脑显卡的显存是6GB因此我选择了7B的版本。 拷贝Ollama命令,并且在控制台运行

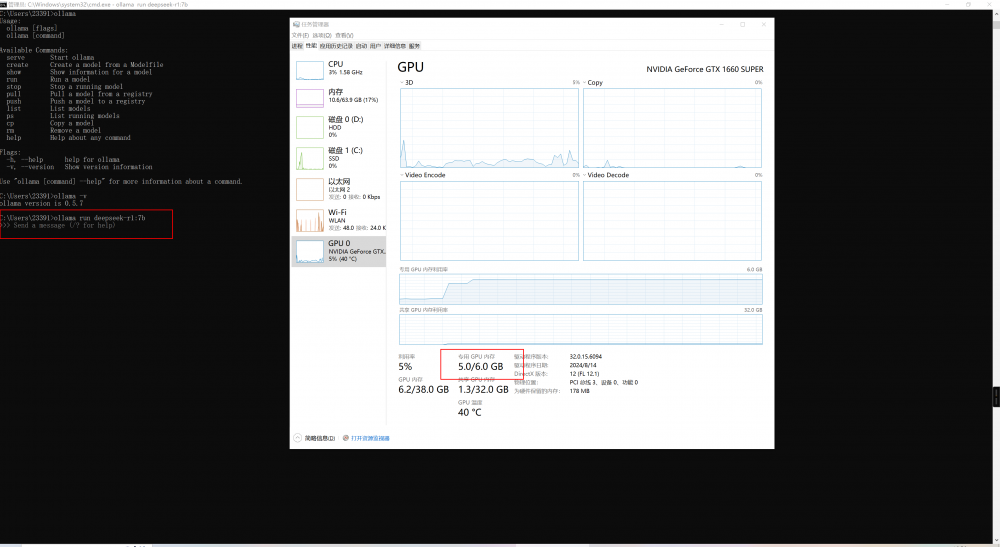

之后Ollama便可以帮你自动的下载这个模型,受限于网速限制这个过程可能持续三分钟。 之后便会帮你自动运行deepseek r1

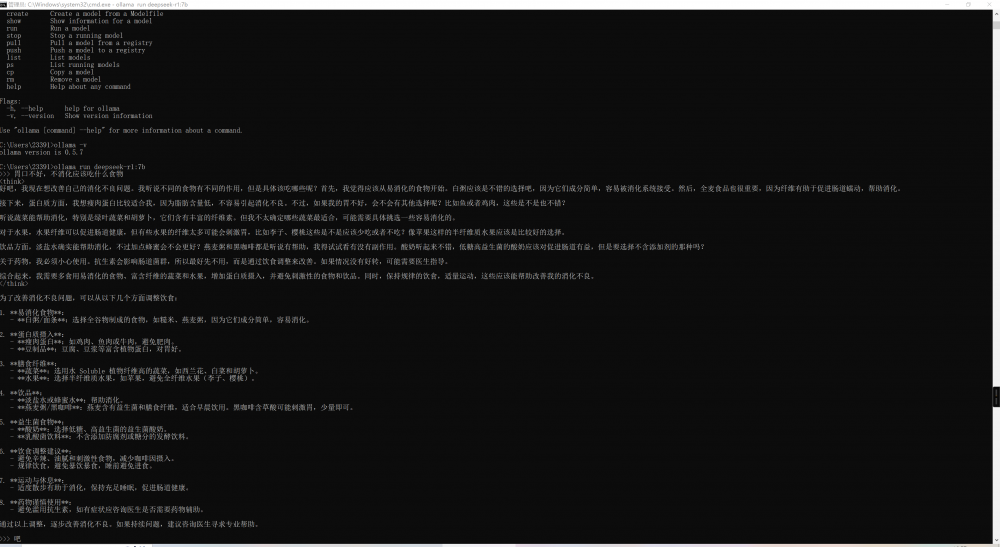

我们来尝试问他一个问题。

响应速度蛮快的,至此安装和运行结束。

我要赚赏金

我要赚赏金