Ollama 是一个轻量化的本地大模型运行框架,支持在消费级硬件(如树莓派)上部署LLM。其优势在于:

提供预优化模型(如Llama2、Mistral等)

简化安装流程(单命令部署)

支持CPU/GPU混合运算

DeepSeek 是深度求索公司研发的开源大语言模型,特点包括:

强大的中文理解能力

7B/67B等多种参数量版本

兼容GGUF量化格式(适合边缘设备)

树莓派5部署步骤环境准备

系统要求:Raspberry Pi OS 64-bit(Bookworm版本)

硬件建议:至少8GB内存 + 主动散热(模型运行时会高负载)

当然,收到的树莓派5 8G开发板足够使用,但是散热。。必须要主动散热,虽然现在不能运行,但是不妨碍安装环境啊。

那么开始。

先打开ollama官网https://ollama.com/ 打开后点击

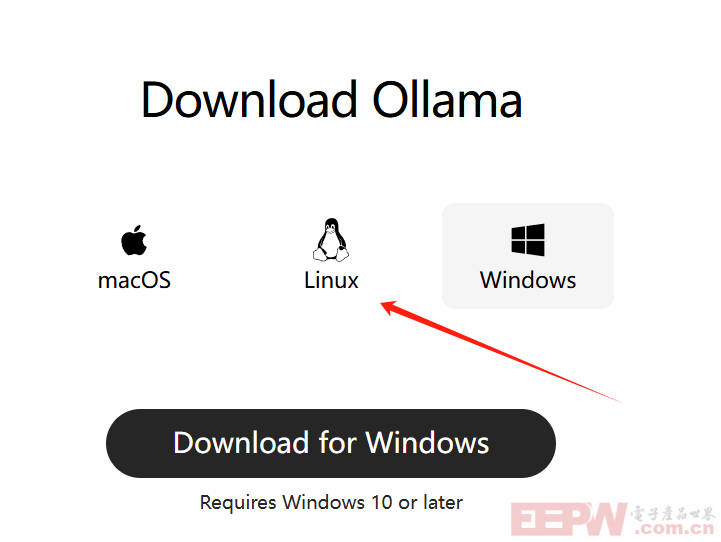

树莓派用的系统也是linux系统一种,那么继续:

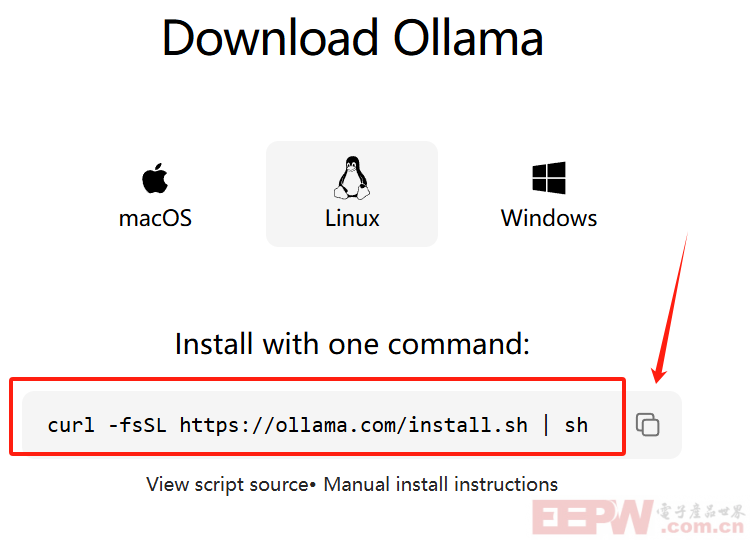

然后复制命令行:

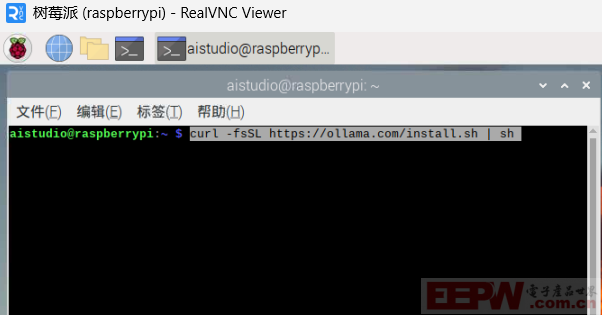

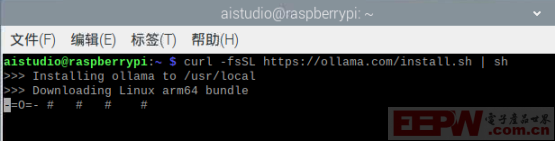

在终端中粘贴运行:

下载,看网速啦。。

下载完成,最好重启:sudo reboot

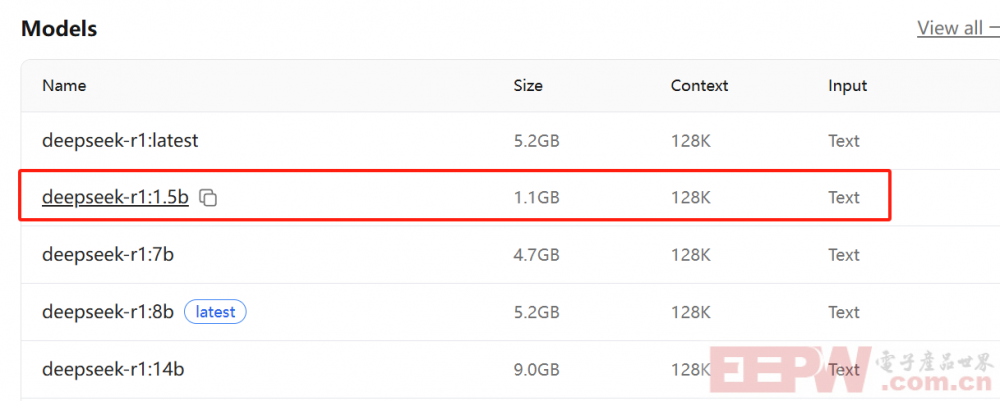

然后还是终端,拉取模型,在https://ollama.com/library 中搜索需要的模型,其中如果选https://ollama.com/library/deepseek-r1,那么打开页面后,

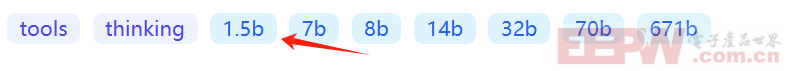

最小的数字,就是最小模型文件:

这里当然用最小的模型了。

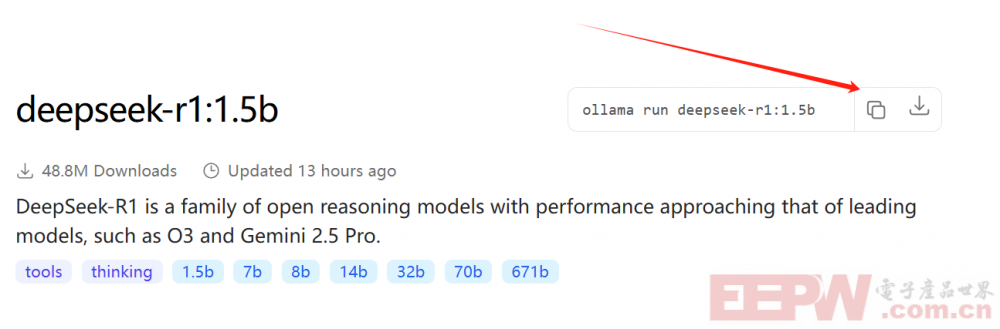

再次点击:

页面中箭头指示就是运行模型,并自动下载,这里我们先下载模型,使用命令:

ollama pull deepseek-r1:1.5b

就会下载1.1G的文件,自动解压模型,然后就可以使用运行测试了。

终端命令:ollama run deepseek-r1:1.5b

具体内容和其他教程大同小异啦。

总结:

本次测试使用树莓派5,介绍了树莓派系统基本情况,开启SSH,VNC的方式,并更新系统,并介绍了如何安装ollama部署deepseek大模型,以及思考,寻找解决方案的过程,可以为相似问题提供参考解决思路。

我要赚赏金

我要赚赏金