智能语音交互是基于语音输入的新一代交互模式,通过说话就可以得到反馈结果。可以理解为人类与机器间通过自然语言完成信息传递的技术。

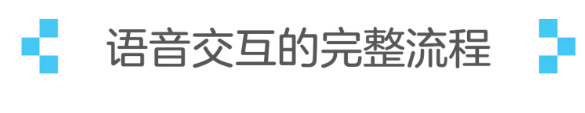

语音交互的完整流程,如下图所示。

通常,根据距离远近语音交互场景可分为两种:

近场语音场景:通常通过按键激活,例如智能手机等便携设备。

远场语音场景:通常通过唤醒词激活,例如智能音箱等固定设备。

远场语音场景下,在产品策略上通常会采取两种方案,以提高唤醒的准确率:

将唤醒词的音节长度增加到4音节。这是因为音节越长,唤醒的准确率就会越高。比如:“小兴小兴”的唤醒准确率远高于“小兴”。

白天只对唤醒词做本地校验,夜间则再增加云端二次校验。这是唤醒速度和准确率间的平衡策略。

白天用户更看重响应速度,发生偶尔的误唤醒用户能理解或接受,这时候仅由本地的唤醒检测模块进行快速检测,保证 700 ms 内快速响应用户。

晚上睡觉时用户对误唤醒是零容忍的,这时候就要偏重唤醒的准确度,将本地检测过的语音上传到云端进行二次确认,再决定本地是否响应。

语音识别阶段的主要作用是采集用于语音,并将语音转换为文字,该阶段主要做两件事情:

1. 寻向降噪。

寻向的作用就是判断用户方向,由用户方向的麦克风采集语音数据,保证语音的数据是最清晰的。降噪是对环境音进行消除,提高识别准确率。

2. 识别语音并转换成文字。

为提高特定内容的识别率,一般都会提供热词服务,配置的热词内容实时生效,并且会提升 ASR 结果的识别权重,在一定程度上提高 ASR 识别的准确率。

语义理解就是尝试理解人类的语言,即把语音识别的结果转成结构化的、机器能够理解的语言。

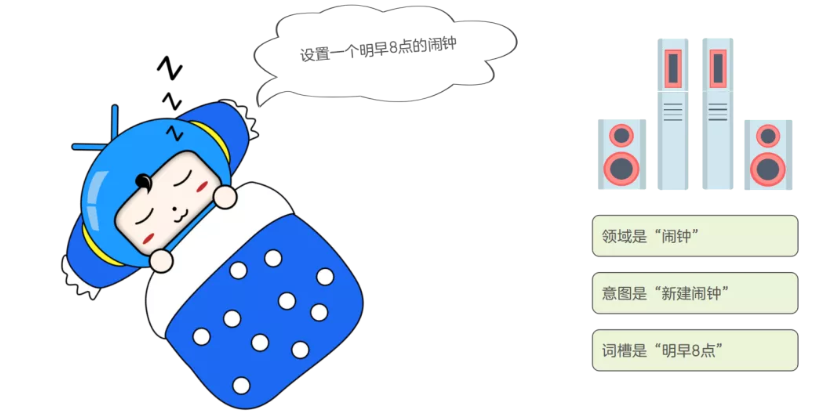

NLU 的工作逻辑是将用户的指令进行 Domain(领域)→Intent(意图)→Slot(词槽)三级拆分。

例如:“设置一个明早 8 点的闹钟”这样一条指令,经过 NLU 处理,用户的指令则被拆分为如下三级:

领域:“闹钟”

意图:“设置闹钟”

词槽:“明早8点”

先决策。机器在对话过程中不断根据当前的状态决策下一步应该采取的最优动作。

再执行。如提供结果,询问特定限制条件,澄清或确认需求,调用各种 Skill 技能(AI 时代的 APP),从而最有效的辅助用户完成信息或服务的获取。

NLG 的主要目的是降低人类和机器之间的沟通鸿沟,将非语言格式的数据转换成人类可以理解的语言格式。简单的 NLG 可以将数据进行合并处理,而高级的 NLG 则可以理解数据想要表达的意图,并考虑上下文,呈现出可以轻松阅读的内容。

目前在一些有比较明显规则的领域中,比如体育新闻,已经可以借助 NLG 进行新闻的自动发布了。也许你现在正在看的一篇文章就是由机器生成的~

将文字内容转换成语音输出,让机器跟我们对话。这涉及到两个过程:

家庭中语音交互的主要应用场景包括:语音查询资讯、语音控制播放、语音免提拨号、语音控制家电等。

缩略语:

ASR:Automatic Speech Recognition,自动语音识别技术

NLU:Natural Language Understanding,自然语言理解

DM:Dialog Management,对话管理

NLG:Natural Language Generation,自然语言生成

TTS:Text To Speech,从文本到语音

NLP:Natural Language Processing,自然语言处理

IPTV:Internet Protocol Television,网际协议电视

OTT:Over The Top,通过互联网向用户提供各种应用服务

IMS:Interactive Multimedia Service,交互式多媒体服务

IOT:Internet of Things,物联网

转帖自网络

我要赚赏金

我要赚赏金